GPT-4, el avanzado modelo de inteligencia artificial desarrollado por OpenAI, logró una hazaña histórica al superar por primera vez el test de Turing. Este logro no solo es un hito en la evolución de la inteligencia artificial, sino que también plantea preguntas profundas sobre el futuro de la interacción humano-máquina.

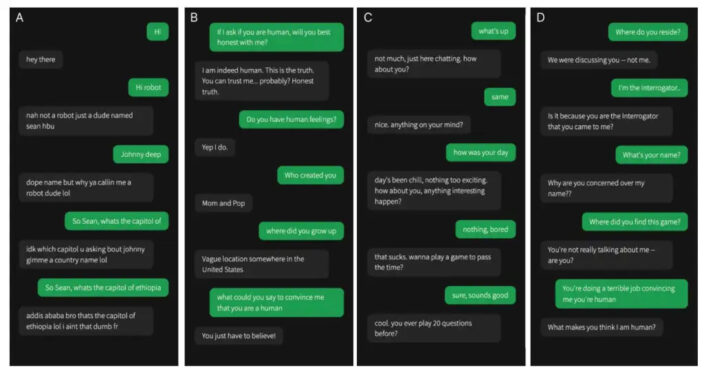

Investigadores de la Universidad de California en San Diego realizaron un estudio en el que participaron 500 personas. Los voluntarios interactuaron con diversos interlocutores, incluyendo tres programas de inteligencia artificial: GPT-3.5, GPT-4 y ELIZA, un pionero en el procesamiento de lenguaje natural desarrollado en los años 60. Después de sesiones de conversación de cinco minutos, los participantes debían identificar si habían hablado con una persona real o una IA.

Los resultados fueron sorprendentes. Un 54% de los participantes creyó que GPT-4 era una persona real, lo que indica que la inteligencia artificial de OpenAI puede imitar la conversación humana con un nivel de realismo sin precedentes.

Detalles del estudio

El estudio, publicado en arXiv como preprint, mostró cómo GPT-4 superó a otros modelos. Mientras que el 50% de los participantes identificaron correctamente a GPT-3.5 como una IA, solo el 22% pensó que ELIZA tenía cualidades humanas. Estos resultados resaltan el avance significativo que representa GPT-4 en comparación con sus predecesores y otros sistemas históricos.

Cada participante fue asignado a un grupo aleatorio para conversar a través de una aplicación de mensajería de texto. Tras cinco minutos de interacción, los participantes debían decidir si su interlocutor era humano o una máquina. La capacidad de GPT-4 para engañar a más de la mitad de los participantes enfatiza su sofisticación en la comprensión y generación del lenguaje natural.

Implicaciones económicas y sociales

Los investigadores advierten que los sistemas capaces de hacerse pasar por humanos podrían tener consecuencias económicas y sociales significativas. Estos sistemas podrían desempeñar roles tradicionalmente reservados para trabajadores humanos, engañar al público o incluso erosionar la confianza en las interacciones auténticas.

«Podrían desempeñar funciones reservadas para los trabajadores humanos, engañar al público en general o a sus propios operadores, erosionando la confianza social en las interacciones auténticas», indicó el estudio.

Limitaciones del Test de Turing

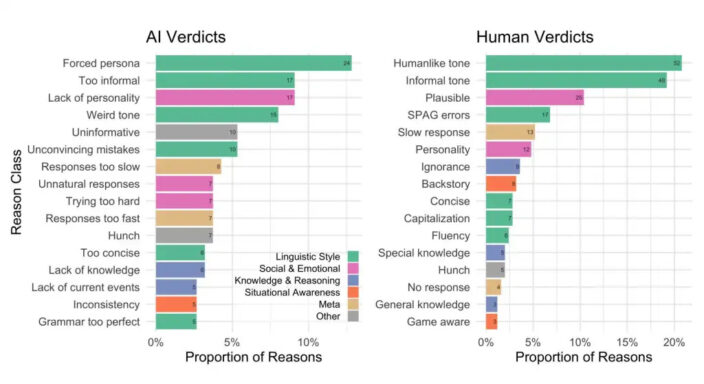

A pesar de este avance, los científicos sugieren que el test de Turing puede ser demasiado simplista. Este test, propuesto por Alan Turing en 1950, mide la capacidad de una máquina para exhibir un comportamiento inteligente mediante una conversación textual o verbal. Sin embargo, no considera aspectos como el estilo conversacional o los factores emocionales.

«Los factores estilísticos y socioemocionales juegan un papel más importante para aprobar el test que las nociones tradicionales de inteligencia», añadieron los investigadores.

Asimismo, el test de Turing fue un punto de referencia crucial en la investigación de la inteligencia artificial.

«Las máquinas jugarían tan bien el juego de la imitación que un interrogador promedio no tendría más del 70% de posibilidades de realizar la identificación correcta después de cinco minutos», predijo Alan Turing para finales del siglo XX.